Spis treści

- Czy musisz się obawiać aktualizacji algorytmu Google?

- Czym jest algorytm Google?

- Jak działa algorytm Google – jak ocenia strony internetowe?

- Jak przebiegają aktualizacje algorytmu Google?

- Jak aktualizacja wyszukiwarki Google wpływa na widoczność stron w wynikach wyszukiwania?

- Jak sprawdzić skutki aktualizacji? Użyj Google Search Console!

- Aktualizacja algorytmu Google z marca 2024 r., czyli walka ze „śmietnikiem treści”

- Helpful Content zintegrowany z głównymi czynnikami rankingowymi

- Nadużywanie wygasłych domen

- Nadużywanie treści na dużą skalę: stop produkcji bezwartościowego contentu

- Nadużywanie reputacji witryny

- Cztery główne aktualizacje wyszukiwarki w 2023 r., czyli silne przetasowanie wyników wyszukiwania

- Google Helpful Content, czyli treści przydatne użytkownikom

- Aktualizacja BERT, czyli model przetwarzania języka naturalnego

- Medical Update, czyli wiarygodność treści w branżach YMYL

- Mobilegeddon, czyli dostosowanie stron do urządzeń mobilnych

- Pigeon, czyli dopasowanie wyników do lokalizacji użytkownika

- Historyczne aktualizacje algorytmów, które zmieniły internet

- Czy na zmiany w algorytmie Google można się przygotować?

- Jak uwzględnić aktualizacje Google w strategii pozycjonowania?

Czy musisz się obawiać aktualizacji algorytmu Google?

W marcu 2024 r. Google znów, po zaledwie kilku miesiącach, ogłosił główną i tym razem naprawdę kompleksową aktualizację algorytmów swojej wyszukiwarki. W sieci zawrzało, bo gigant uprzedził, że będzie skutecznie zwalczał nieuczciwe praktyki SEO. Zapewnił, że z SERP-ów (czyli wyników wyszukiwania: z ang. Search Engine Results Page) zniknie nawet 40% treści wątpliwej jakości. Że strony www z wyprodukowaną masowo i nieużyteczną zawartością zostaną uznane za spam, a techniki manipulacji wynikami wyszukiwania – ukrócone.

To pociągnęło za sobą lawinę pytań, zwłaszcza o wykorzystanie do tworzenia tekstów i innych treści sztucznej inteligencji. Wielu właścicieli stron i sklepów online zaczęło niepokoić się o widoczność swoich serwisów w sieci – a więc również o rentowność swoich projektów – i zastanawiać nad sensem inwestycji w SEO. Czy słusznie?

Uspokajamy – aktualizacje algorytmów Google wprowadzało już wielokrotnie i z całą pewnością będzie to nadal co jakiś czas robić. Jeśli w swojej strategii SEO grasz uczciwie – nie stosujesz praktyk Black Hat, lecz uwzględniasz wskazówki i zalecenia giganta, możesz spać spokojnie. Wszystkie historyczne oraz bieżące zmiany w wyszukiwarce Google uderzają w osoby, które próbują oszukać system albo po prostu zaniedbują jakość (czyli użyteczność, sprawność, bezpieczeństwo, estetykę) swoich stron. Rzecz jasna, zwłaszcza podczas wprowadzania zmian oraz tuż po ich zakończeniu nawet jakościowe serwisy mogą zanotować drobne zmiany w pozycjach i widoczności, ale nie oznacza to, że Twoja strona po aktualizacji algorytmu pogrąży się w odmętach internetu. Wręcz przeciwnie – może zyskać w rankingu.

W praktyce sprawa jest jednak dosyć skomplikowana, a w dodatku skąpana w aurze tajemniczości, na której łatwo budować różne stereotypy, mity i obawę o przyszłość. Dlatego przygotowaliśmy dla Ciebie wyczerpujący poradnik, w którym omawiamy największe zmiany algorytmów Google ostatnich lat oraz ich wpływ na widoczność stron w internecie i strategię pozycjonowania.

Czym jest algorytm Google?

Przede wszystkim wyszukiwarka Google to nie jeden algorytm, ale cały ich zestaw. To złożony pakiet procedur, na podstawie których system wyszukuje, indeksuje i ocenia wszystkie istniejące strony internetowe, dopasowując je do zapytania użytkownika w kolejności od najbardziej do najmniej trafnego wyniku.

Algorytmy Google są utajnione; nie wiemy, jak dokładnie działają, jednak firma upublicznia zasadnicze informacje i wskazówki dla twórców stron i specjalistów SEO. Dzięki nim i własnemu doświadczeniu możemy z powodzeniem poprawiać pozycje stron internetowych w wynikach wyszukiwania Google. A śledząc historię aktualizacji algorytmów i ogłoszenia, możemy przygotowywać się na zmiany.

Google dąży do tego, aby zapewnić użytkownikom wyszukiwarki najtrafniejsze, najbardziej pomocne wyniki – dlatego najwyższe pozycje w rankingach zajmują strony uchodzące za maksymalnie użyteczne i wartościowe. W tym też celu gigant regularnie aktualizuje cały system czy poszczególne jego elementy, aby jeszcze lepiej dopasowywać wyniki wyszukiwania do zapytań.

Jak działa algorytm Google – jak ocenia strony internetowe?

- Analizowanie zapytań użytkowników – algorytmy starają się zrozumieć, czego konkretnie użytkownik szuka, w jakim kontekście i jakie są jego intencje. Chce uzyskać informacje, a może znaleźć i kupić jakiś produkt lub usługę? Istotnym przełomem w tym obszarze było wdrożenie w 2019 r. algorytmu BERT – czyli zaawansowanego modelu przetwarzania języka naturalnego w wyszukiwarce, który radzi sobie już z odmianą słów, zaimkami, homonimami czy związkami frazeologicznymi. Jeszcze wcześniej, w 2013, dzięki aktualizacji o wdzięcznej nazwie Hummingbird (Koliber) Google przestał polegać tylko na dopasowaniu słów kluczowych, a zaczął rozumieć zależności między składnikami zapytania.

- Indeksowanie stron internetowych – boty internetowe Google skanują strony i zbierają o nich różne informacje, takie jak: czego dotyczy ich zawartość, czy są użyteczne i godne zaufania oraz z jakimi zapytaniami użytkowników się łączą. Google wykorzystuje setki czynników rankingowych (ocenianych elementów), a te najważniejsze znamy. Wytyczne co do tych branych pod uwagę elementów strony są przedmiotem aktualizacji algorytmów. Przykładowo w 2015 r. dzięki wdrożeniu Mobilegeddon na znaczeniu zyskały strony zoptymalizowane pod urządzenia mobilne. Google walczy również ze spamem, który był istotnym obiektem głównej aktualizacji algorytmu z marca 2024 r.

- Ocena oraz porządkowanie stron w wynikach wyszukiwania – na podstawie zebranych informacji algorytmy tworzą i uaktualniają ranking stron: decydują, które najlepiej odpowiadają konkretnym zapytaniom. Jak wspomnieliśmy, czynników rankingowych są setki, a jednym z najważniejszym jest E-E-A-T (ang. Experience, Expertise, Authoritativeness, Trustworthiness), czyli doświadczenie użytkownika, eksperckość, autorytet i wiarygodność strony oraz jej twórców. W ten sposób wyniki wyszukiwania są porządkowane, a pierwsze pozycje zajmują najbardziej użyteczne i jakościowe strony internetowe. W tej mierze Google ciągle dopasowuje się do oczekiwań i potrzeb użytkowników, stąd aktualizacje takie jak Helpful Content czy jeden z ostatnich update’ów z marca 2024 r.

Jak przebiegają aktualizacje algorytmu Google?

W praktyce każda aktualizacja algorytmu Google niewiele różni się od aktualizacji oprogramowania czy aplikacji na telefonie, w komputerze. System zostaje po prostu udoskonalony, unowocześniony, lepiej dopasowany do potrzeb odbiorcy. Algorytmy skuteczniej rozpoznają intencje użytkowników i wartościowe, pomocne treści, a na drugim biegunie – także witryny spamerskie i te o wątpliwej użyteczności. Dzięki temu lepiej dopasowują wyniki wyszukiwania do zapytania.

Aktualizacja może obejmować podstawową lub większą część systemu (nazywamy ją wówczas główną aktualizacją, z ang. core update) bądź jakiś jego mały element. Core update’ów w całej historii Google mieliśmy już dziesiątki, w tym cztery tylko w 2023 r. Zmiany o mniejszym zasięgu pojawiają się znacznie częściej, to np. reviews updates obejmujące autentyczność i rzetelność opinii o produktach i usługach. Mogą również dotyczyć konkretnego problemu, jak np. dominacja pojedynczych domen w wynikach wyszukiwania (rozwiązała go aktualizacja Site Diversity Update) czy wręcz przeciwnie – jakiejś całej branży (jak aktualizacja Medical Update, związana z wiarygodnością stron medycznych i innych typu YMYL: „Your Money Your Life”).

Google nie wyjawia, na czym dokładnie polegają zmiany algorytmów: podobnie jak nie ujawnia samego systemu. Informuje jednak, jakie nowe zasady wprowadza i co one zmienią oraz jak się do nich dostosować.

Jak aktualizacja wyszukiwarki Google wpływa na widoczność stron w wynikach wyszukiwania?

Tak naprawdę Google aktualizuje wyszukiwarkę nieustannie, nawet kilka tysięcy razy w ciągu roku. Większość takich zmian to „kosmetyka”, która raczej nie wpływa na wyniki wyszukiwania. Inaczej ma się natomiast sprawa z większymi i głównymi aktualizacjami, które z reguły powodują przetasowanie pozycji stron w wyszukiwarce. Niektóre witryny notują wówczas spadki, a inne wzrost swoich pozycji – w zależności od tego, jak korespondują z nowymi wytycznymi i procedurami. Każda taka aktualizacja ma jeden cel, którym jest poprawa jakości wyników wyszukiwania. Nie dziwi więc, że Google zwykle zaostrza swoje wymagania, choć zdarza się też, że kolejną aktualizacją łagodzi wcześniejszą politykę. Świetnym przykładem są treści generowane przez AI, z którymi gigant najpierw chciał walczyć, a teraz nie ma z nimi problemu, pod warunkiem że są użyteczne dla odbiorców.

Jak sprawdzić skutki aktualizacji? Użyj Google Search Console!

Niezależnie od tego, czy sam(-a) pozycjonujesz stronę, czy korzystasz z usług agencji SEO lub freelancera, możesz łatwo sprawdzić, jak aktualizacja algorytmu wpłynęła na jej widoczność. Użyj do tego bezpłatnego narzędzia Google Search Console, które pozwala monitorować pozycje (i inne wyniki strony, np. liczbę kliknięć) oraz identyfikować błędy i problemy.

Google dąży do tego, żeby użytkownicy jego wyszukiwarki mogli sprawnie uzyskać możliwie najlepszą odpowiedź na swoje zapytanie, wpisywane w postaci fraz i słów kluczowych. Im lepiej Twoja strona odpowiada zapytaniu i intencji użytkownika, im bardziej jest godna zaufania i atrakcyjna, tym większa szansa na to, że na aktualizacji zyskasz lub przynajmniej nie zanotujesz spadków. Jeśli zaś nie dostarczasz odbiorcy wartości, nie dbasz o sprawność, bezpieczeństwo czy estetykę strony, to – mimo że optymalizujesz ją pod SEO i stosujesz link building – musisz się liczyć z tym, że może spaść w rankingu. Spójrzmy na przykłady, czyli najważniejsze aktualizacje algorytmu Google z ostatnich kilku lat.

Aktualizacja algorytmu Google z marca 2024 r., czyli walka ze „śmietnikiem treści”

Po kilku miesiącach od ostatnich dużych aktualizacji systemu (bo w 2023 r. Google zaserwowało ich aż cztery) w marcu 2024 r. gigant ogłosił kolejną, jeszcze większą i bardziej kompleksową. Jej główne założenia to nacisk na użyteczne, wysokiej jakości treści i wyeliminowanie z wyników wyszukiwania stron „śmieciowych”, spamerskich, tworzonych tylko po to, by generować kliknięcia. Według szacunków z SERP-ów ma zniknąć nawet 40% treści: bezwartościowy, powielany content. Ponieważ aktualizacje obejmują wiele systemów podstawowych, możemy zaobserwować większe niż zwykle wahania pozycji stron w rankingach. Natomiast Google jasno wskazuje:

Co się zmieniło?

Helpful Content zintegrowany z głównymi czynnikami rankingowymi

W 2022 r. Google zaktualizował podstawowe czynniki rankingowe oraz wprowadził system przydatności treści Helpful Content, który premiuje wartościowe treści tworzone z myślą o użytkownikach, a nie o algorytmach. Teraz gigant go rozwinął i uzupełnił o wiele dodatkowych systemów czy sygnałów, które identyfikują przydatność i wiarygodność informacji na poziomie zarówno konkretnej strony, jak i całej witryny. Nie jest to rewolucja, ale raczej ewolucja, natomiast razem z wprowadzeniem trzech nowych zasad dotyczących spamu zdecydowanie wpływa na pozycjonowanie stron i wyniki procesów. Ulepszenie możliwości wykrywania spamu ogranicza widoczność tych stron, które stosują nieuczciwe praktyki SEO i manipulują wynikami wyszukiwania. Co zostało ukrócone?

Nadużywanie wygasłych domen

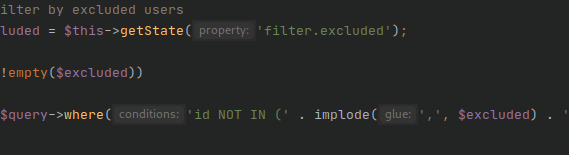

Polega to na tym, że kupujesz wygasłą nazwę domeny, tworzysz stronę i zapełniasz ją treściami zapleczowymi, „preclowymi”, które nie dają żadnej lub wystarczającej wartości użytkownikom. Wykorzystujesz historię i reputację domeny, które są ważnymi czynnikami rankingowymi, aby wypozycjonować nową stronę czy tylko po to, aby umieszczać na niej linki do swojej głównej strony lub innych witryn (czyli ją zmonetyzować). Przejmujesz domenę używaną wcześniej np. przez witrynę medyczną, z aktywnymi backlinkami (prowadzą do niej odnośniki umieszczone na innych stronach) i sporym ruchem organicznym oraz zapełniasz ją treścią słabej jakości, aby zmanipulować wyniki wyszukiwania. Takie działania zostaną ukrócone i nie będą się już opłacać. Oczywiście wciąż możesz wykorzystywać wygasłe domeny, ale musisz budować na nich wartościowe strony, tworzone z myślą o użytkownikach, a nie o robotach i algorytmach.

Nadużywanie treści na dużą skalę: stop produkcji bezwartościowego contentu

Nadużycie treści to sytuacja, w której tworzysz wiele stron internetowych tylko po to, aby zmanipulować wyszukiwarkę Google, a nie by dostarczać jej użytkownikom wartości i pomocy. Gigant mówi stop produkcji dużych ilościtreści opierających się wyłącznie lub głównie na obecności fraz i słów kluczowych. Nie ma znaczenia, czy ich autorem jest człowiek, AI, mieszarka, czy może łączysz te metody (np. generujesz teksty z AI i je opracowujesz). Jeśli content na stronie nie jest wystarczająco pomocny dla użytkownika, zostanie ona uznana na spam i „wyleci” z rankingu, nie będzie pojawiać się w wynikach wyszukiwania. Rzecz jasna wciąż możesz tworzyć blogi i strony satelitarne dla swojej głównej witryny, jednak muszą one reprezentować stosowną jakość. Możesz też generować teksty z AI i je publikować, nawet bez „czynnika ludzkiego”, czyli ich opracowania, ale muszą być merytoryczne i pomocne dla odbiorców.

Nadużywanie reputacji witryny

Z taką sytuacją mamy do czynienia wówczas, gdy osoby trzecie tworzą i publikują słabej jakości strony niezależne od witryny hostującej i nienadzorowane przez nią, aby wykorzystywać sygnały rankingowe i reputację tej domeny. Są to np. strony sponsorowane, reklamowe, partnerskie o znikomej wartości dla użytkownika, służące wyłącznie manipulacji wynikami wyszukiwania i tworzone bez wiedzy, zaangażowania lub nadzoru witryny hostującej. Nie dotyczy to jednak takich witryn, które umożliwiają publikację artykułów sponsorowanych i reklam natywnych, pod warunkiem że zarówno te strony, jak i ich zawartość są dla odbiorców użyteczne i dają im wartość. Wciąż możesz pozyskiwać linki do swojej domeny w innych witrynach (link building) i korzystać z reklamy natywnej, jednak musisz zwrócić uwagę na wiarygodność swoich partnerów.

Cztery główne aktualizacje wyszukiwarki w 2023 r., czyli silne przetasowanie wyników wyszukiwania

Jak wspomnieliśmy, wielka aktualizacja algorytmu Google z marca 2024 r. jest raczej ewolucją i kontynuuje założenia zmian wdrażanych w latach poprzednich. Rok 2023 był pod tym względem rekordowy, bo gigant zdecydował się na aż cztery aktualizacje główne: podstawowe, modyfikując i liberalizując wiele wcześniejszych założeń. Poza tym pojawiło się jeszcze sporo pomniejszych zmian.

- Zmiana podejścia do treści generowanych przez AI. Algorytm Google miał premiować treści „tworzone dla ludzi przez ludzi”, ale wydaje się, że wraz z aktualizacjami z 2023 r. środek ciężkości przesunął się na pierwszy człon tego założenia. Nie wiemy dokładnie, w jaki sposób algorytm wyszukiwarki Google ustala pochodzenie i autorstwo treści. Jednak dopóki są użyteczne i wartościowe, metody ich tworzenia mają drugorzędne znaczenie. Wygląda na to, że strona z contentem generowanym przez AI, nawet bez żadnego wsparcia człowieka, może osiągać wysokie pozycje w wynikach wyszukiwania, jeśli tylko spełnia te założenia. Z kolei strony, które zawierają treści niskiej jakości, także te napisane przez człowieka, nie mogą liczyć na przychylność systemu.

- Treści autoryzowane, ale niekoniecznie tworzone przez ekspertów. Istotą sukcesu w wynikach wyszukiwania jest wiarygodność treści. Początkowo Google zakładał, że powinny być tworzone przez specjalistów danej dziedziny. Jednak trudno za takich uznać wielu copywriterów, marketerów czy właścicieli firm, a mimo to są oni w stanie tworzyć dobry, wiarygodny, użyteczny content. W przypadku wrażliwych branż chodzi o to, by treści były autoryzowane przez specjalistów. Możesz publikować teksty np. medyczne bądź prawnicze, ale aby zajmowały wysokie pozycje w wynikach wyszukiwania, powinien zatwierdzić je ekspert. Współpraca copywritera i specjalisty danej dziedziny popłaca. Ten pierwszy wie, jak stworzyć dobry content, a drugi zadba o jego wiarygodność.

- Aktualizacja treści na stronie nie może dotyczyć tylko daty. Google dba o to, aby treści pojawiające się w wynikach wyszukiwania były możliwie najbardziej aktualne. Dlatego ważnym elementem strategii SEO jest recykling i odświeżanie contentu. Gigant zaczął jednak brać pod uwagę zakres tego typu zmian – próby manipulacji, takie jak np. samo uaktualnienie daty wpisu bez znaczących modyfikacji samej treści, nie przynoszą już większych efektów.

- Treści stron trzecich jako sygnał rankingowy dla całej witryny. Jeśli na swojej stronie głównej lub subdomenie publikujesz artykuły sponsorowane i inne treści partnerskie bądź afiliacyjne, to mogą one wpływać na ocenę całej domeny. Dlatego tak ważne jest, aby tego typu treści również były wartościowe i użyteczne oraz zoptymalizowane względem fraz i słów kluczowych. Działa to w dwie strony. Jeśli udostępniasz powierzchnię swojej strony osobom trzecim, wymagaj jakościowego contentu mimo tego, że dostajesz za to pieniądze. Jeśli zamawiasz publikację na stronach zewnętrznych, również postaraj się tworzyć jakościowe teksty niezależnie od tego, że za usługę musisz zapłacić.

- Aktualizacja systemu recenzji (reviews update). Jak poinformował Google, była to ostatnia oficjalnie upubliczniona zmiana w systemie recenzji. Dotyczy on takich treści (np. opinii, ale też rankingów i artykułów na blogu), które recenzują i rekomendują produkty czy usługi. Google coraz mocniej dba o ich wiarygodność: taki content należy tworzyć z perspektywy użytkownika i eksperta oraz uzupełniać go o przydatne dane, zdjęcia czy filmy i porównania. Zasadniczą sprawą jest także wiarygodne uzasadnienie swojego stanowiska.

Google Helpful Content, czyli treści przydatne użytkownikom

Kilkakrotnie wspomnieliśmy o Google Helpful Content, czyli o systemie przydatności treści. Wprowadzono go w 2022 r. i wywołał w internecie spore zamieszanie, istotnie wpływając na wyniki wyszukiwarki Google. Obecnie jest jednym z najważniejszych czynników rankingowych. A w praktyce polega na ocenie, czy dana treść jest pomocna, wartościowa i wiarygodna i czy stworzono ją dla człowieka – niezależnie od tego, kto jest jej autorem (człowiek czy AI lub inny program). Nawet świetnie zoptymalizowany i nasycony frazami kluczowymi content nie gwarantuje przychylności wyszukiwarki Google, jeśli jego wartość merytoryczna jest znikoma.

Na co zwrócić uwagę?

- Prawdziwość i wiarygodność informacji. Nie możesz wprowadzać w błąd użytkowników wyszukiwarki Google. Rzetelny research i fact-checking są absolutną podstawą i najlepiej korzystać w tym celu z przynajmniej dwóch czy trzech wiarygodnych źródeł (np. publikacji naukowych i wpisów ekspertów). Dotyczy to zwłaszcza treści generowanych przez AI (której zdarza się naciągać i zniekształcać rzeczywistość), ale nie tylko. Ogranicz zaufanie także do wiedzy swojej i swoich współpracowników lub zewnętrznych wykonawców.

- Użyteczność treści, czyli informacje konkretne i praktyczne. Pewnie zdarzyło Ci się kiedyś zapytać Google, czy najbliższa niedziela jest handlowa – i przebrnąć przez historię oraz ocenę zmian w polskim prawodawstwie, zanim poznałeś(-aś) odpowiedź na to pytanie (jeśli w ogóle…). To trochę śmieszny, a trochę smutny przykład i rodzaj branżowego żartu, ale właśnie takich praktyk musisz unikać. Jasne: obszerne i wyczerpujące treści także są użyteczne, lecz trzeba skupić się na konkretach związanych z danym zapytaniem użytkownika. Uważaj też na clickbaitowe nagłówki, które mogą wprowadzać w błąd.

- Naturalne użycie i rozmieszczenie słów i fraz kluczowych w tekście. Nawet najbardziej użyteczna treść raczej nie przełoży się na wysokie pozycje w wyszukiwarce Google, jeśli nie będzie dobrze zoptymalizowana oraz nasycona frazami kluczowymi. Jednak nie możesz przedobrzyć – zbyt wiele fraz i użycie ich bez kontekstu albo niezgodne z zasadami językowymi (np. w niewłaściwej nieodmienionej formie) algorytm Google wyłapie szybko i skutecznie. Treści powinny być tworzone dla ludzi, a nie dla robotów. Koszmarki w stylu „jeśli szukasz elektryk Warszawa” nie tylko nie pomogą, ale też zaszkodzą, zarówno w kwestii pozycji strony, jak i wiarygodności oraz wizerunku firmy.

- Unikatowość treści i przestrzeganie praw autorskich. Algorytm Google potrafi doskonale rozpoznać duplikację treści oraz plagiat i obydwie te praktyki piętnuje. Nie umieszczaj więc tej samej lub podobnej treści na kilku podstronach czy subdomenach: lepiej zadziała jeden jakościowy content. Nie kradnij też cudzej własności: nie kopiuj treści, a jeśli chcesz wykorzystać jej fragmenty, zrób to na prawie cytatu. Trudno dziś odkryć coś nowego i często powielamy informacje, które już ktoś wykorzystał. Staraj się jednak zawsze coś od siebie dodać np. swoje spojrzenie na sprawę, case study czy ciekawostkę.

Aktualizacja BERT, czyli model przetwarzania języka naturalnego

W 2019 r. Google ogłosił dużą aktualizację algorytmu polegającą na wdrożeniu BERT (Bidirectional Encoder Representations From Transformers), czyli technologii NLP – przetwarzania języka naturalnego przy wykorzystaniu sztucznej inteligencji. Do tej pory algorytm Google odkodowywał zapytania linearnie i pojedynczo. Dzięki BERT zaczął rozumieć i przetwarzać osobno każdy wyraz zapytania razem z ich łącznikami i odkodowywać istniejące między nimi relacje znaczeniowe, a tym samym – kontekst i sens intencji użytkownika. Innymi słowy, Google już wie, że użytkownik wpisujący w wyszukiwarkę zbitkę „elektryk warszawa tanio” szuka niedrogiego fachowca w Warszawie, który obsługuje raczej klientów indywidualnych aniżeli duże firmy. Potrafi także lepiej rozumieć dłuższe i bardziej złożone frazy tzw. długiego ogona (np. „elektryk płyta indukcyjna warszawa”).

Aktualizacja algorytmu nie przyniosła dużych zmian w pozycjach stron w wynikach wyszukiwania, ale odbiła się na SEO. Sprawiła, że teksty mogą być naturalniejsze (np. „tani elektryk w Warszawie”), i umożliwiła pozyskiwanie ruchu organicznego także ze złożonych wyszukiwań („elektryk do podłączenia płyty indukcyjnej w Warszawie”). A tym samym zapewniła nowe skuteczne strategie pozycjonowania stron – zwłaszcza mniejszym firmom z ograniczonym budżetem.

BERT uzupełnił algorytm RankBrain, dzięki któremu roboty mogą też rozpoznawać homonimy w zależności od intencji użytkownika (np. „zamek”) czy sugerować strony związane z zapytaniem, ale niezawierające użytych w nim fraz kluczowych. Od kilku lat Google pracuje ponadto nad algorytmem SMITH, który ma uzupełnić BERT, aby umożliwić robotom analizę, zrozumienie i ocenę dłuższych treści: całych tekstów czy dokumentów. Potencjalne zastosowania algorytmu SMITH obejmują ulepszenia w rozumieniu całości contentu na stronach internetowych, co może wpłynąć na wyniki wyszukiwania i rekomendacje.

Medical Update, czyli wiarygodność treści w branżach YMYL

Z kolei w 2018 r. sporo zamieszania w internecie wywołała aktualizacja Google znana jako Medical Update. Dotyczyła głównie serwisów i stron skorelowanych ze zdrowiem i medycyną, ale w szerszym ujęciu również wszystkich branż „Your Money Your Life”, czyli związanych z podejmowaniem przez klientów istotnych życiowych decyzji oraz inwestycją pieniędzy, m.in. branży finansowej. Wówczas Google mocno przetasował wyniki wyszukiwania, banując za błędy merytoryczne, niewiarygodne źródła informacji i przekazy, które mogły wprowadzać w błąd lub wywierać wpływ na odbiorców w nieetyczny sposób – np. nachalnie zachęcając ich do skorzystania z oferty. Na znaczeniu zyskały natomiast treści użyteczne i tworzone przez (lub z udziałem) rzeczywistych ekspertów, a więc np. lekarzy, prawników, ekonomistów itd.

Mobilegeddon, czyli dostosowanie stron do urządzeń mobilnych

Dziś już większość użytkowników wyszukiwarki Google najczęściej korzysta z niej na urządzeniach mobilnych – smartfonach i tabletach. Ten trend zyskiwał na sile przez lata i gigant technologiczny podjął wiele wysiłków, by na niego odpowiedzieć. Jedną z najważniejszych aktualizacji algorytmu pod tym kątem był Mobilegeddon. W 2015 r. Google uwzględnił w czynnikach rankingowych, jak strony prezentują się i działają na urządzeniach mobilnych. Z tego względu, żeby uzyskiwać wysokie pozycje w wyszukiwarce, trzeba koniecznie (rzecz jasna poza spełnieniem pozostałych wytycznych) zadbać o pełną responsywność witryny.

Ponadto dwa lata później ogłoszono jeszcze aktualizację Google Intrusive Interstitials Mobile Penalty. W związku z nią algorytm zaczął obniżać widoczność w wyszukiwarce takich stron, które wyświetlały inwazyjne, wyskakujące okienka (tzw. pop-upy) bądź pełnoekranowe reklamy utrudniające dostęp do głównej treści strony (bezpośrednio po przejściu z wyników wyszukiwania lub w trakcie przeglądania zawartości).

Pigeon, czyli dopasowanie wyników do lokalizacji użytkownika

W 2014 r. głośnym echem odbił się Pigeon, czyli aktualizacja wspierająca wyniki wyszukiwania lokalnego. W praktyce algorytmy wyszukiwania lokalnego zostały zintegrowane z głównymi – i zaczęły wykorzystywać podobne czynniki rankingowe. Google wprowadził rozwiązania, które pozwoliły dostarczać odbiorcom najtrafniejsze wyniki na podstawie bliskości ich lokalizacji względem poszukiwanych miejsc – sklepów czy salonów i punktów usługowych. Jednocześnie pojawiły się także zmiany w liczbie firm w lokalnym „pakiecie” wyników, co zmusiło przedsiębiorców do bardziej zawziętej rywalizacji. Prowadzący biznesy stacjonarne musieli postarać się o silniejszą obecność w internecie oraz zadbać o optymalizację strony i wizytówki Google Moja Firma pod względem lokalnym.

Historyczne aktualizacje algorytmów, które zmieniły internet

Prześledziliśmy wspólnie 10 lat aktualizacji algorytmów Google – omówiliśmy kilka najważniejszych, chociaż było ich znacznie więcej i każda też wniosła do internetu coś nowego. Jedną z najbardziej rewolucyjnych była pierwsza aktualizacja wyszukiwarki Google, czyli wprowadzenie algorytmu Panda, a kolejno Pingwina. To one przyczyniły się do wycofania w 2016 r. wskaźnika PageRank, który oceniał strony internetowe na podstawie liczby prowadzących do nich odnośników. Gigant zaczął mocniej stawiać na jakość i użyteczność treści oraz naturalne budowanie autorytetu domeny poprzez profil linków (ich jakość, a nie ilość).

W SEO stopniowo przestało działać upychanie słów kluczowych i tworzenie ogromnej ilości treści o niskiej wartości czy produkowanie farm linków. Obecnie ten proces jest dużo bardziej złożony i wymagający, ale przynosi to korzyści wszystkim: zarówno właścicielom stron i sklepów internetowych, jak i ich odbiorcom, klientom: użytkownikom wyszukiwarki. W końcu co z tego, że strona zajmie pierwszą czy drugą pozycję w wynikach wyszukiwania na określoną frazę, jeśli w rzeczywistości nie odpowiada potrzebom czy intencji użytkownika? Samo jej wypozycjonowanie to jedno, ale chodzi przecież o to, żeby odbiorca faktycznie wykonał na niej pożądane działanie, np. kupił produkt czy skontaktował się z przedstawicielem firmy.

Czy na zmiany w algorytmie Google można się przygotować?

Google nie upublicznia swoich systemów, więc również nie informuje, co konkretnie w nich zmienia. Wyjaśnia raczej główny obszar i cel aktualizacji oraz daje wskazówki, jak przystosować do niej strony internetowe. Niemniej każdy specjalista SEO zawsze ma z tyłu głowy zarówno przeszłe, jak i spodziewane zmiany. Jeśli sam(-a) zajmujesz się pozycjonowaniem swojej witryny, również musisz je uwzględnić.

Kolejne aktualizacje algorytmu Google mają charakter ewolucyjny. Wynikają z poprzednich zmian, z obserwowanych potrzeb użytkowników i trendów. Jeśli stosujesz się do bieżących wytycznych i jesteś z Google „na czasie”, zmiany tego typu nie muszą spędzać Ci snu z powiek. Na aktualizacjach tracą głównie strony, których twórcy stosują nieuczciwe praktyki SEO oraz nie dbają o jakość projektów. O pozycje strony trzeba też walczyć ciągle – ich spadki wcale nie muszą być związane ze zmianami systemowymi, a np. z działaniem konkurencji. Dlatego trzeba je regularnie monitorować oraz wciąż optymalizować stronę, tak aby coraz lepiej odpowiadała na zapytania użytkowników związane z jej ofertą czy tematyką.

Jak uwzględnić aktualizacje Google w strategii pozycjonowania?

Algorytm Google zmienia się i udoskonala, jednak od zawsze wszystkie te działania zmierzają w jednym celu: poprawy doświadczenia użytkownika wyszukiwarki. Z tego względu czynniki rankingowe Google, główne założenia, wskazówki dla deweloperów i specjalistów SEO są w zasadzie niezmienne – mimo kolejnych aktualizacji. Stosując się do wytycznych i dobrych praktyk, przeżyjesz je bez stresu i większych rewolucji.

Co trzeba wziąć pod uwagę?

- Użyteczne, wiarygodne i dobrze zoptymalizowane treści. Wypełnij swoją stronę jakościową treścią, uwzględniającą (naturalnie!) słowa czy frazy kluczowe, na które chcesz zajmować wysokie pozycje w Google. Zwróć uwagę na prawdziwość informacji oraz zadbaj o to, aby content był praktyczny, czyli rzeczywiście pomagał użytkownikowi zaspokoić jego potrzeby.

- Przejrzysta nawigacja na stronie i wskazówki dla robotów Google. Zatroszcz się o to, aby użytkownik mógł łatwo odnaleźć się na stronie – stwórz czytelną nawigację i wdroż linkowanie wewnętrzne. Jednocześnie pomóż nieco robotom Google: zoptymalizuj kod i metadane, przygotuj plik robots.txt i zgłoś stronę do indeksowania, jeśli jest z tym problem.

- Prawidłowe działanie, bezpieczeństwo i szybkość ładowania strony. Must-have to protokół HTTPS, certyfikat SSL, eliminacja błędów i stworzenie stosownych przekierowań oraz responsywność na urządzeniach mobilnych. Strona musi działać szybko i sprawnie, a jej użytkownik powinien móc łatwo i intuicyjnie wykonać na niej pożądane działanie, np. kupić produkt.

- Budowanie autorytetu strony, pozyskiwanie wartościowych linków. Regularnie współpracuj z wydawcami stron branżowych i tematycznych bądź lifestylowych, powiązanych z tematyką swojej witryny i ofertą firmy. Pozyskuj na takich serwisach (im większe i popularniejsze, tym lepiej!) odnośniki: linki do swojej strony, które wzmocnią jej wiarygodność i autorytet.

- Aktualizacja treści, unowocześnianie strony i bycie na bieżąco z Google. Pracuj nad swoją stronę nieustannie, starając się dostarczać coraz więcej wartości użytkownikom i odpowiadając na ich potrzeby (analizuj je!). Stosuj się do wytycznych Google i śledź bieżące zmiany, dopasowując do nich swoją stronę. Regularnie monitoruj pozycje strony i działania konkurencji.

Tak – to wszystko wymaga czasu, wiedzy, doświadczenia i wsparcia narzędziowego, a nad całym tym procesem powinien pracować sztab specjalistów, od specjalistów SEO i deweloperów, po copywriterów, projektantów i edytorów. Jeśli nie zatrudniasz ich w swojej firmie, pomyśl o skorzystaniu z usługi agencji SEO takiej jak nasza Empressia. Zadbamy o widoczność Twojej strony w wyszukiwarce, dzięki której zrealizujesz cele biznesowe, rozwiniesz swój projekt i zwiększysz zyski. Zapraszamy!

wyceń pozycjonowanie strony internetowej

FAQ:

1. Jak często zmienia się algorytm Google?

Algorytm Google jest aktualizowany nawet kilka tysięcy razy w roku, czyli w zasadzie nieustannie. Większość zmian to jednak drobnostki, które nie wpływają na wyniki wyszukiwania. Podstawowy system uaktualniany jest co kilka, kilkanaście miesięcy.

2. Na czym polegają aktualizacje algorytmu Google?

Google ciągle ulepsza swój algorytm, tak aby zapewniać użytkownikom najtrafniejsze wyniki wyszukiwania. Nie upublicznia jednak zarówno samego systemu, jak i opisu konkretnych zmian: jedynie ich obszar i cel i wskazówki, jak się do nich dostosować.

3. Czy w wyniku aktualizacji algorytmu Google strona traci pozycje?

Niekoniecznie, po aktualizacji algorytmu strona może też wskoczyć na wyższe pozycje lub pozostać na tych samych. Zmiany algorytmów Google wpływają negatywnie na strony z contentem niskiej jakości oraz takie, w których procesie pozycjonowania wykorzystuje się nieuczciwe praktyki np. nadużywanie wygasłych domen.